Comment a été ce contenu ?

Boosted.ai’s generative AI portfolio manager surfaces near-instant finance insights with AWS

En passant d’un LLM générique trop vaste et encombrant pour ses besoins à un modèle adapté à son domaine (les marchés des capitaux), Boosted.ai a réduit ses coûts de 90 %, considérablement amélioré son efficacité et a débloqué la capacité GPU nécessaire pour faire mettre à l’échelle son application de gestion de placements basée sur l’IA générative.

Récapitulatif

En 2020, Boosted.ai a étendu sa plateforme d’analyse financière basée sur l’intelligence artificielle (IA), Boosted Insights, en créant un assistant de portefeuille basé sur l’IA pour les gestionnaires d’actifs sur un grand modèle de langage (LLM) qui a traité des données provenant de 150 000 sources. Le résultat consistait en des informations macroéconomiques et une analyse des tendances du marché sur plus de 60 000 actions portant sur tous les marchés boursiers mondiaux (Amérique du Nord, UE et Royaume-Uni, Asie-Pacifique, Moyen-Orient, Amérique latine et Inde). L’utilisation d’un LLM présentait toutefois des inconvénients importants : un coût annuel d’exploitation élevé et des limites de capacité du GPU qui entravaient leur capacité d’évolution.

Boosted.ai a commencé à optimiser le domaine d’un modèle exécuté sur AWS et :

- a réduit les coûts de 90 % sans sacrifier la qualité ;

- est passé des mises à jour quotidiennes de nuit à des mises à jour en temps quasi réel, offrant ainsi plus de valeur à leurs clients gestionnaires de placements en utilisant des centaines de milliers de sources de données ;

- a amélioré la sécurité et la personnalisation grâce à la possibilité d’exécuter un modèle dans le cloud privé d’un client, plutôt que d’exécuter des charges de travail via un cloud LLM.

Introduction

2023 a été l’année où l’IA générative s’est généralisée. L’amélioration de l’efficacité pour faire plus avec moins continuera de figurer à l’ordre du jour des entreprises tout au long de l’année 2024 et au-delà. Il est essentiel que les équipes disposent d’une stratégie pour intégrer l’IA générative dans le but de générer des gains de productivité. Cependant, même lorsqu’il existe un cas d’utilisation clair, il n’est pas toujours évident de savoir comment mettre en œuvre l’IA générative de manière à ce qu’elle ait un sens au regard des résultats financiers de l’entreprise.

Voici comment Boosted.ai a intégré l’IA générative pour automatiser les tâches de recherche pour ses clients de gestion de placements, de manière à améliorer les résultats à la fois pour l’entreprise et pour ses clients.

Fondée en 2017, Boosted.ai propose une plateforme d’IA et de machine learning (ML), Boosted Insights, destinée à aider les gestionnaires d’actifs à trier les données afin d’améliorer leur efficacité, d’améliorer les indicateurs de leur portefeuille et de prendre de meilleures décisions fondées sur les données. Lorsque les fondateurs ont constaté l’impact de puissants LLM, ils ont décidé d’utiliser un LLM à code source fermé pour créer un assistant de gestion de portefeuille alimenté par l’IA. Du jour au lendemain, elle traiterait des millions de documents provenant de 150 000 sources, y compris des jeux de données non traditionnels tels que les dossiers déposés auprès de la SEC tels que les 10K et 10Q, les appels de revenus, les publications spécialisées, les actualités internationales, les actualités locales et même la mode. Après tout, si vous parlez de l’introduction en bourse d’une entreprise comme Shein, un article de Vogue pourrait devenir une information d’investissement pertinente. Boosted Insights a résumé et rassemblé toutes ces informations dans une interface utilisateur interactive que ses clients gestionnaires d’actifs peuvent trier eux-mêmes.

Grâce à son nouveau modèle d’IA générative, Boosted.ai transmet désormais des informations d’investissement critiques à tous ses clients, à savoir plus de 180 des plus grands gestionnaires d’actifs du monde. Pour ces équipes, le temps c’est de l’argent. Lorsque quelque chose a un impact sur le cours des actions d’une entreprise, la rapidité avec laquelle une personne obtient ces informations et agit en fonction de ces informations peut faire la différence de milliers, voire de millions d’USD. Boosted.ai donne un avantage à ces managers. Par exemple, elle a indiqué qu’Apple transférait certaines de ses capacités de fabrication en Inde avant que la nouvelle ne soit diffusée dans les principaux médias, car Boosted Insights lisait des articles dans les médias indiens.

L’ajout d’une composante d’IA générative à Boosted Insights a automatisé une grande partie des recherches visant à transformer une hypothèse d’investissement en une transaction réelle. Par exemple, si un investisseur est préoccupé par une guerre commerciale avec la Chine, il peut demander à Boosted Insights : « Quels types d’actions dois-je acheter ou vendre ? » Avant l’IA générative, répondre à cette question nécessitait un processus de recherche de 40 heures, passant au crible des centaines de pages de rapports d’analystes, d’articles de presse et de résumés des bénéfices. Avec un assistant de gestion de portefeuille alimenté par l’IA, 80 % de ce travail est désormais automatisé.

Résolution d’échelle à l’aide de modèles de langage spécifiques à un domaine

Le déploiement de l’IA générative de Boosted.ai a été extrêmement bien accueilli par les clients, mais l’entreprise souhaitait l’étendre pour effectuer jusqu’à cinq ou dix fois plus d’analyses et passer de rapports instantanés à un véritable système en temps réel. Mais il y avait un problème : faire fonctionner l’IA coûtait près d’un million d’USD par an en frais, et même si l’entreprise voulait acheter plus de capacité GPU, elle ne pouvait tout simplement pas le faire. La capacité GPU n’était en fait pas suffisante pour que leur outil d’analyse financière basé sur l’IA puisse devenir une application en temps réel.

Ajustement du modèle pour réduire les coûts et augmenter la mise à l’échelle

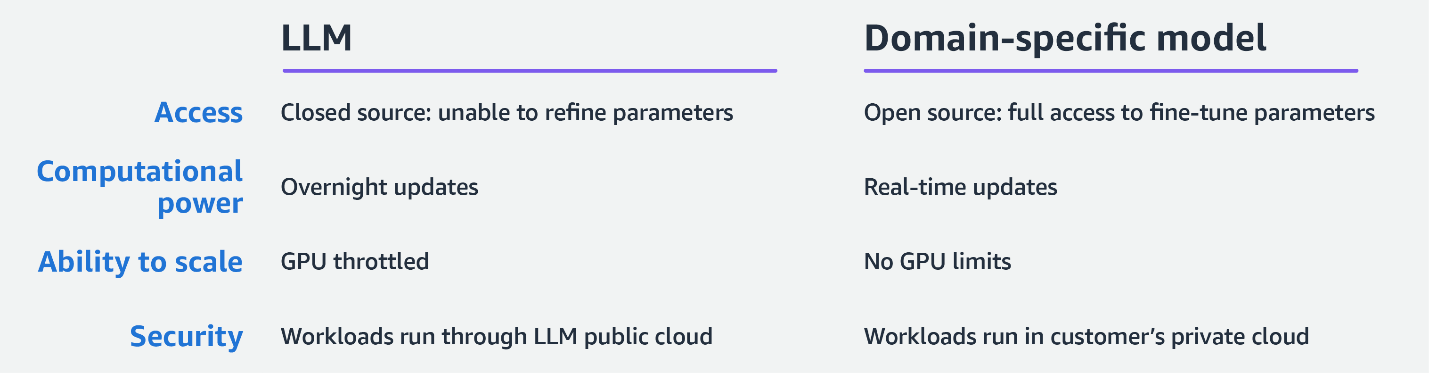

Les défis rencontrés par Boosted.ai sont des défis de plus en plus courants pour les organisations qui adoptent les LLM et l’IA générative. Étant donné que les LLM sont entraînés pour un usage général, les entreprises qui entraînent ces modèles consacrent beaucoup de temps, de tests et d’argent à leur mise en œuvre. Plus le modèle est grand, plus le calcul accéléré nécessaire à chaque requête est important. Par conséquent, pour la plupart des organisations, y compris Boosted.ai, il n’est tout simplement pas viable d’utiliser un LLM pour une tâche spécifique.

Boosted.ai a décidé d’explorer une approche plus ciblée et plus rentable : affiner un modèle de langage plus petit pour effectuer une tâche spécifique. Dans le monde de l’IA et du ML, ces modèles sont souvent qualifiés d’ « open source », mais cela ne signifie pas qu’ils sont bricolés par des personnes lambda partageant un wiki, comme vous pourriez l’imaginer aux premiers jours du codage open source. Au lieu de cela, les modèles de langage open source, tels que Llama 2 de Meta, sont entraînés sur des milliers de milliards de points de données et gérés dans des environnements sécurisés tels qu’Amazon Bedrock. La différence est qu’un modèle open source donne aux utilisateurs un accès total à ses paramètres et la possibilité de les ajuster pour des tâches spécifiques. Les LLM à code source fermé, en revanche, sont une boîte noire qui ne permet pas le type de personnalisation que Boosted.ai doit créer.

La possibilité d’affiner leur modèle ferait toute la différence pour Boosted.ai. Par le biais du réseau de Partenaires AWS, Boosted.ai s’est connecté à Invisible, dont le réseau mondial de spécialistes de la formation à l’IA a permis à Boosted.ai de rester concentrée sur son travail de développement principal, tandis qu’Invisible fournissait des annotations de données de haute qualité plus rapidement et de manière plus rentable que le recrutement d’une équipe interne pour le projet. Ensemble, AWS, Invisible et Boosted.ai ont trouvé et mis en œuvre le modèle le plus petit possible capable de gérer leur cas d’utilisation, en le comparant au jeu de données MMLU (Massive Multitask Language Understanding) standard du secteur pour évaluer les performances.

« Notre objectif était de disposer du modèle le plus petit possible avec le QI le plus élevé possible pour nos tâches. Nous sommes allés dans le MMLU et avons examiné les sous-tâches que nous jugions hautement pertinentes par rapport à l’activité de Boosted.ai : microéconomie et macroéconomie, mathématiques, et quelques autres domaines. Nous avons choisi le plus petit modèle qui, selon nous, fonctionnerait le mieux possible et l’avons adapté au mieux à nos tâches. Si cela ne fonctionnait pas, nous passions au modèle de taille supérieure et au niveau d’intelligence suivant. »– Joshua Pantony, Boosted.ai co-founder and CEO

Grâce à un modèle plus compact et plus efficace tout aussi performant en matière d’analyse financière, Boosted.ai a réduit ses coûts de 90 %. Le principal avantage de cette efficacité était la possibilité d’augmenter considérablement la quantité de données qu’ils extrayaient, en passant de mises à jour quotidiennes de nuit à des mises à jour en temps quasi réel. Plus important encore, ils ont obtenu les GPU dont ils avaient besoin pour se mettre à l’échelle. Alors que Boosted.ai avait autrefois besoin de l’A100 et du H100 pour exécuter ses modèles, cette IA générative plus efficace et spécifique à un domaine lui a permis d’exécuter une couche sur du matériel plus petit et plus facilement disponible.

Sécurité et personnalisation accrues grâce à un modèle plus petit

Après avoir affiné un modèle plus petit avec la même efficacité, Boosted.ai disposait de la capacité de calcul nécessaire pour effectuer encore plus d’analyses. Désormais, au lieu de traiter les données durant la nuit, ils pourraient traiter les données chaque minute et promettre à leurs clients un délai de cinq à dix minutes seulement entre le moment où un événement se produit et sa prise en compte par Boosted Insights.

Le modèle a également donné à Boosted.ai plus d’options quant à l’endroit et à la manière dont ils se déploient. Avec un LLM, Boosted.ai envoyait la charge de travail vers un cloud à code source fermé, récupérait les résultats, puis les stockait. Ils peuvent désormais effectuer un déploiement dans le cloud privé virtuel (VPC) d’un autre client sur AWS pour une sécurité accrue.

« Disposer d’une stratégie d’IA générative sera l’une des exigences fondamentales des sociétés de gestion de placements en 2024, et nous constatons une forte demande de la part d’entreprises souhaitant gérer leurs données internes via notre IA générative pour créer des agents intelligents. Naturellement, l’exploitation de données propriétaires soulève des problèmes de confidentialité. Beaucoup de nos utilisateurs se sentent plus en sécurité avec notre modèle que dans un grand LLM à code source fermé. 90 % de nos clients ont un compte AWS, et l’avantage que nous constatons est qu’il est extrêmement simple de protéger leurs données dans leur cloud AWS privé lorsque nous fonctionnons sur le même cloud. »

« Il est beaucoup plus facile de donner accès à des déploiements privés qui exécutent leurs données que d’essayer de tout créer à partir de zéro. »– Joshua Pantony

Grâce à la tranquillité d’esprit supplémentaire qu’offre un point de terminaison privé, de plus en plus de clients sont prêts à partager leurs données propriétaires pour créer des informations plus personnalisées. Par exemple, un fonds spéculatif peut avoir accès à des entretiens avec des centaines de directeurs financiers et d’analystes de gestion. Ce jeu de données est trop précieux et trop confidentiel pour être envoyé à un point de terminaison d’API public. Avec l’approche spécifique au domaine de Boosted.ai, ce partage n’est pas nécessaire. L’ensemble de la charge de travail s’exécute dans le cloud du client, qui obtient des informations plus personnalisées.

L’avenir : des modèles linguistiques spécifiques à un domaine et une nouvelle façon de tirer parti de l’expertise

Au fur et à mesure de la croissance du plus petit modèle de langage de Boosted.ai, les informations qu’il offre deviendront plus précises et plus quantifiées. Par exemple, il peut aujourd’hui indiquer quelles entreprises sont touchées par un événement, comme la guerre en Ukraine. À l’avenir, il sera en mesure de quantifier cet effet et de dire : « exactement 7 % du chiffre d’affaires de cette entreprise sera affecté, et voici la probabilité de son impact ».

En outre, l’obtention de ces informations nécessitera moins d’interactions de la part de l’utilisateur. Il sera possible de charger votre expertise et vos connaissances dans votre IA personnalisée, de la faire scanner une vaste base de données d’informations, de manière à ce qu’elle vous propose des idées uniques.

L’IA est la technologie la plus rapidement adoptée de l’histoire de l’humanité, et pour les petites entreprises, les cas d’utilisation de pointe actuels devraient constituer un enjeu majeur dans quelques années à peine.

« Nous traversons une période vraiment unique de l’histoire où de nombreuses grandes entreprises ne connaissent pas le potentiel de cette technologie et l’adoptent de manière sous-optimale. Vous voyez une tonne de chatbots monter à gauche, à droite et au centre. Si vous êtes une start-up aujourd’hui, rencontrez des clients, découvrez leurs problèmes et découvrez ce dont l’IA générative est capable. Si vous le faites, il y a de fortes chances que vous trouviez une valeur ajoutée unique. »

« Lorsque vous êtes sûr d’avoir une certaine adéquation produit-marché, j’envisagerais d’affiner les modèles plus petits par rapport aux LLM en termes de vitesse, de précision et de sensibilité des données. Si vous pensez que l’un d’entre eux est essentiel pour votre cas d’utilisation, le recours à un modèle spécifique à un domaine en vaut probablement la peine. »– Joshua Pantony

Merci également à Invisible pour sa contribution à ce projet et à cet article. Invisible est une société d’innovation opérationnelle qui fusionne de manière fluide l’IA et l’automatisation avec une main-d’œuvre qualifiée afin de surmonter les obstacles liés à l’exécution stratégique.

Ryan Masciovecchio

Ryan is a Solutions Architect at AWS living in Toronto, Canada. He provides technical advice to startups, allowing them to build innovative products using emerging technologies. Ryan has over 15 years of experience, from racking servers and configuring networking appliances to building infrastructure for web applications using cloud services. Ryan enjoys learning how technology can be used in creative ways to simplify people’s lives.

Deepam Mishra

Deepam Mishra is a Sr Advisor to Startups at AWS and advises startups on ML, Generative AI, and AI Safety and Responsibility. Before joining AWS, Deepam co-founded and led an AI business at Microsoft Corporation. Deepam has been a serial entrepreneur and investor, having founded 4 AI/ML startups in areas such as security, enterprise software and healthcare. He was the VP of New Ventures at Wipro Technologies and co-founded Venture Studio, a startup incubator, and seed-fund. He has created multiple successful startups, including SightLogix, EyeIC, Green-Power-Systems, Shippr, and more. Deepam has a BSEE from IIT Kanpur, an MSEE from Texas A&M, and an MBA from The Wharton School. He has 5 US patents and numerous publications. He is based in the Silicon Valley.

Joshua Pantony

Josh is a co-founder and CEO of Boosted.ai, an AI company that brings advanced ML tools to institutional investors and wealth managers. Since starting Boosted.ai in 2017, the company has helped hundreds of investment managers implement machine learning in their portfolios. Prior to founding Boosted.ai, Josh was a Principal ML engineer at Bloomberg for 4 years. At Bloomberg, he helped start and build numerous critical ML initiatives including Ranking, Recommendation, Question and Answering, Crowd Sourcing, and Knowledge Graphs. He also acted as a consultant on numerous initiatives across the company and helped build several ML teams. As a student at the University of Waterloo, Josh co-founded his first company, Maluuba, a deep learning natural language processing company. At Maluuba, he built the earliest prototype, recruited the entire ML team, and oversaw general technology development from 4 people up to a 30 person company. He has 8 patents to his name all of which are core Maluuba IP. Maluuba was later bought by Microsoft.

Comment a été ce contenu ?