Wie war dieser Inhalt?

Der generative KI-Portfoliomanager von Boosted.ai liefert mit AWS nahezu sofortige Finanzinformationen

Durch den Wechsel von einem generischen LLM, das für seine Anforderungen zu umfangreich und umständlich war, auf ein auf seine Domain (Kapitalmärkte) zugeschnittenes Modell konnte Boosted.ai die Kosten um 90 Prozent senken, die Effizienz erheblich verbessern und die GPU-Kapazität freisetzen, die zum Skalieren seiner generativen KI-Investmentmanagement-Anwendung erforderlich war.

Zusammenfassung

Im Jahr 2020 erweiterte Boosted.ai seine auf künstliche Intelligenz (KI) gestützte Finanzanalyseplattform Boosted Insights, indem es einen KI-Portfolioassistenten für Vermögensverwalter auf Basis eines großen Sprachmodells (LLM) entwickelte, das Daten aus 150 000 Quellen verarbeitete. Das Ergebnis waren Makroeinblicke und Markttrendanalysen zu über 60 000 Aktien in allen globalen Aktienmärkten (Nordamerika, EU und Vereinigtes Königreich, Asien-Pazifik, Naher Osten, Lateinamerika und Indien). Die Verwendung eines LLM brachte jedoch einige erhebliche Nachteile mit sich: hohe jährliche Betriebskosten und GPU-Kapazitätsbeschränkungen, die die Skalierbarkeit einschränkten.

Boosted.ai begann mit der Domainoptimierung eines Modells, das in AWS ausgeführt wird, und:

- reduzierte die Kosten um 90 Prozent ohne Qualitätseinbußen;

- wechselte von Updates über Nacht zu Updates in nahezu Echtzeit und schuf so einen größeren Mehrwert für Investmentmanager-Kunden, die auf Hunderttausende von Datenquellen zugreifen;

- verbesserte Sicherheit und Personalisierung mit der Möglichkeit, ein Modell in der privaten Cloud eines Kunden auszuführen, anstatt Workloads über eine LLM-Cloud auszuführen.

Einführung

2023 war das Jahr, in dem generative KI zum Mainstream wurde. Die Steigerung der Effizienz, um mit weniger mehr zu erreichen, wird auch im Jahr 2024 und darüber hinaus auf der Tagesordnung der Unternehmen stehen. Für Teams ist es wichtig, eine Strategie zu haben, wie sie generative KI integrieren, um Produktivitätssteigerungen zu erzielen. Doch selbst wenn ein klarer Anwendungsfall vorliegt, ist nicht immer klar, wie generative KI auf eine Weise implementiert werden kann, die für das Geschäftsergebnis eines Unternehmens sinnvoll ist.

So integrierte Boosted.ai generative KI, um Rechercheaufgaben für seine Investmentmanagement-Kunden zu automatisieren, um sowohl für Boosted.ai als auch für seine Kunden bessere Ergebnisse zu erzielen.

Boosted.ai wurde 2017 gegründet und bietet mit Boosted Insights eine Plattform für KI und Machine Learning (ML), die Vermögensverwaltern dabei hilft, Daten zu sortieren, um ihre Effizienz zu steigern, ihre Portfoliokennzahlen zu verbessern und bessere, datengesteuerte Entscheidungen zu treffen. Als die Gründer die Wirkung leistungsstarker LLMs erkannten, beschlossen sie, mithilfe eines Closed-Source-LLM einen KI-gestützten Portfoliomanagement-Assistenten zu erstellen. Über Nacht verarbeitete dieser Millionen von Dokumenten aus 150 000 Quellen, darunter nicht-herkömmliche Datensätze wie SEC-Anmeldungen wie 10Ks und 10Qs, Telefonkonferenzen zu Quartalsergebnissen, Fachzeitschriften, internationale Nachrichten, lokale Nachrichten und sogar Mode. Wenn es um den Börsengang eines Unternehmens wie Shein geht, könnte ein Artikel in der Vogue schließlich zu einer relevanten Investitionsinformation werden. Boosted Insights fasste all diese Informationen in einer interaktiven Benutzeroberfläche zusammen, die die Kunden der Vermögensverwalter selbst durchsuchen konnten.

Mit seinem neuen generativen KI-Modell übermittelte Boosted.ai nun allen seinen Kunden, über 180 der größten Vermögensverwalter der Welt, wichtige Anlageinformationen. Für diese Teams ist Zeit Geld. Wenn sich etwas auf den Aktienkurs eines Unternehmens auswirkt, kann die Geschwindigkeit, mit der jemand diese Informationen erhält und darauf reagiert, den Unterschied von Tausenden oder sogar Millionen von Dollar ausmachen. Boosted.ai hat diesen Managern einen Vorteil verschafft. So hat Boosted.ai beispielsweise darauf hingewiesen, dass Apple einen Teil seiner Produktionskapazitäten nach Indien verlagert, bevor dies in den Massenmedien bekannt wurde, da Boosted Insights Artikel indische Medien gelesen hat.

Durch das Hinzufügen einer generativen KI-Komponente zu Boosted Insights wurde ein Großteil der Recherche automatisiert, um aus einer Investitionshypothese einen tatsächlichen Handel zu machen. Wenn ein Anleger zum Beispiel über einen Handelskrieg mit China besorgt ist, könnte er Boosted Insights fragen: „Welche Arten von Aktien sollte ich kaufen oder verkaufen?“ Vor der generativen KI war die Beantwortung dieser Frage ein 40-stündiger Rechercheprozess, bei dem Hunderte von Seiten mit Analystenberichten, Nachrichtenartikeln und Gewinnzusammenfassungen durchforstet werden mussten. Mit einem KI-gestützten Portfolio-Management-Assistenten wurden 80 Prozent dieser Arbeit automatisiert.

Skalieren mit domainspezifischen Sprachmodellen

Die Einführung der generativen KI von Boosted.ai wurde von den Kunden äußerst positiv angenommen, doch das Unternehmen wollte sie skalieren, um bis zu 5- oder 10-mal mehr Analysen durchzuführen und von Berichten über Nacht zu einem echten Echtzeitsystem zu gelangen. Es gab jedoch ein Problem: Der Betrieb der KI kostete fast 1 Million USD pro Jahr an Gebühren, und selbst wenn sie mehr GPU-Kapazität kaufen wollten, konnten sie dies einfach nicht. Für die Skalierung ihres KI-Finanzanalyse-Tools in eine Echtzeitanwendung reichte die GPU-Kapazität einfach nicht aus.

Richtiges Dimensionieren des Modells für niedrigere Kosten und größeren Maßstab

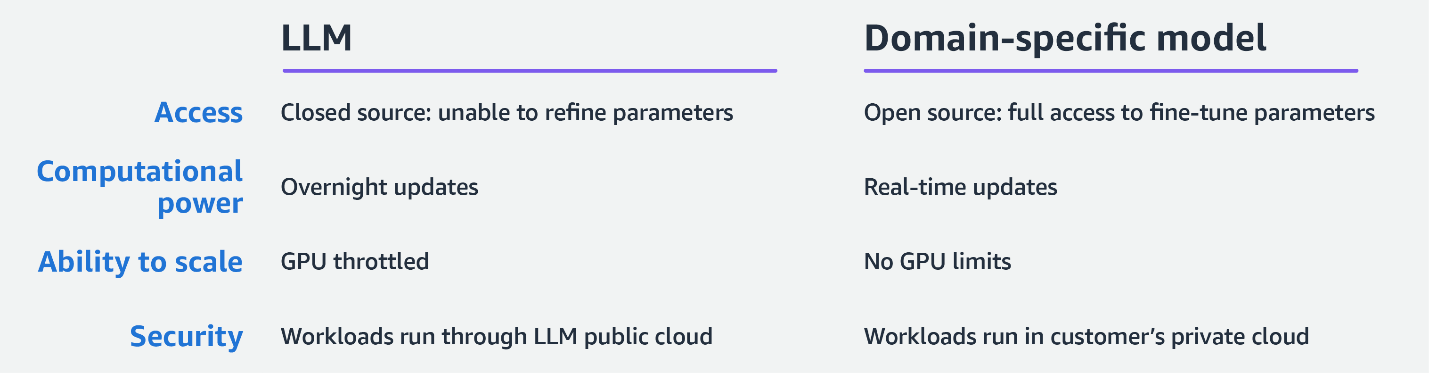

Die Herausforderungen von Boosted.ai treten für Unternehmen, die LLMs und generative KI einführen, immer häufiger auf. Da LLMs für den allgemeinen Gebrauch trainiert werden, investieren die Unternehmen, die diese Modelle trainieren, viel Zeit, Tests und Geld, um sie in Betrieb zu nehmen. Je größer das Modell, desto mehr beschleunigte Rechenleistung muss bei jeder Anfrage verwendet werden. Daher ist es für die meisten Unternehmen, einschließlich Boosted.ai, einfach nicht sinnvoll, ein LLM für eine bestimmte Aufgabe zu verwenden.

Boosted.ai entschied sich für einen gezielteren und kostengünstigeren Ansatz: Die Feinabstimmung eines kleineren Sprachmodells zur Ausführung einer bestimmten Aufgabe. In der KI/ML-Welt werden diese Modelle oft als „Open Source“ bezeichnet, aber das bedeutet nicht, dass sie von zufällig ausgewählten Leuten in einem gemeinsamen Wiki zusammengehackt werden, wie man es aus den Anfängen der Open-Source-Programmierung vielleicht vermuten könnte. Stattdessen werden Open-Source-Sprachmodelle wie Llama 2 von Meta anhand von Billionen von Datenpunkten trainiert und in sicheren Umgebungen wie Amazon Bedrock verwaltet. Der Unterschied besteht darin, dass ein Open-Source-Modell den Benutzern vollständigen Zugriff auf seine Parameter und die Möglichkeit gibt, diese für bestimmte Aufgaben zu optimieren. Im Gegensatz dazu sind Closed-Source-LLMs eine Blackbox, die nicht die Art von Anpassung zulässt, die Boosted.ai für die Erstellung benötigt.

Die Möglichkeit, ihr Modell zu optimieren, machte für Boosted.ai den entscheidenden Unterschied aus. Über das AWS-Partnernetzwerk knüpfte Boosted.ai Kontakt zu Invisible. Dessen globales Netzwerk aus KI-Trainingsspezialisten ermöglichte es Boosted.ai, sich auf seine Kernentwicklungsarbeit zu konzentrieren, während Invisible schneller und kostengünstiger hochwertige Datenannotationen bereitstellte, als dies bei der Besetzung des Projekts mit einem eigenen Team möglich gewesen wäre. Gemeinsam fanden und implementierten AWS, Invisible und Boosted.ai das kleinstmögliche Modell, das für ihren Anwendungsfall geeignet war, und verglichen die Leistung mit dem branchenüblichem Massive Multitask Language Understanding (MMLU, Massives Multitasking-Sprachverständnis)-Datensatz.

„Unser Ziel war es, das kleinstmögliche Modell mit dem höchstmöglichen IQ für unsere Aufgaben zu haben. Wir gingen in die MMLU und sahen uns Teilaufgaben an, von denen wir dachten, dass sie für die Arbeit von Boosted.ai sehr relevant sind: Mikro- und Makroökonomie, Mathematik und einige andere. Wir schnappten uns das kleinste Modell, von dem wir dachten, dass es funktionieren würde, und optimierten es so, dass es für unsere Aufgaben am besten geeignet war. Wenn das nicht funktionierte, gingen wir zum nächstgrößeren Modell und zur nächsthöheren Intelligenzstufe über.“– Joshua Pantony, Boosted.ai co-founder and CEO

Mit einem kompakteren und effizienteren Modell, das bei Finanzanalysen genauso gut funktionierte, konnte Boosted.ai die Kosten um 90 Prozent senken. Der große Vorteil, den sie in dieser Effizienz sahen, bestand darin, dass sie die Menge der abgerufenen Daten massiv steigern konnten – von Aktualisierungen über Nacht bis hin zu Aktualisierungen in nahezu Echtzeit. Und was noch wichtiger war: Sie erhielten die GPUs, die sie zur Skalierung brauchten. Wo Boosted.ai einst A100 und H100 zum Ausführen seiner Modelle benötigte, ermöglichte ihnen diese effizientere domainspezifische generative KI, eine Ebene auf kleinerer und leichter verfügbarer Hardware auszuführen.

Mehr Sicherheit und Anpassungsmöglichkeiten mit einem kleineren Modell

Durch die Feinabstimmung eines kleineren Modells mit der gleichen Wirksamkeit verfügte Boosted.ai über die Rechenkapazität, um noch mehr Analysen durchzuführen. Anstatt Daten über Nacht zu verarbeiten, konnten sie Daten jetzt jede Minute verarbeiten und den Kunden eine Verzögerung von nur 5 bis 10 Minuten zwischen dem Ereignis und der Erfassung durch Boosted Insights versprechen.

Das Modell gab Boosted.ai außerdem mehr Wahlfreiheit hinsichtlich des Einsatzortes und der Art der Bereitstellung. Mit einem LLM konnte Boosted.ai den Workload an eine Closed-Source-Cloud auslagern, die Ergebnisse abrufen und diese dann speichern. Nun kann Boosted.ai für zusätzliche Sicherheit innerhalb der Virtual Private Cloud (VPC) eines anderen Kunden in AWS bereitstellen.

„Eine generative KI-Strategie wird im Jahr 2024 eine grundlegende Erwartung für Investmentunternehmen sein, und wir sehen eine große Nachfrage von Unternehmen, die ihre internen Daten durch unsere generative KI ausführen lassen wollen, um intelligente Kundendienstmitarbeiter zu schaffen. Verständlicherweise wirft die Nutzung firmeneigener Daten Bedenken hinsichtlich des Datenschutzes auf. Viele unserer Benutzer fühlen sich bei unserem Modell sicherer als bei einem großen Closed-Source-LLM. 90 Prozent unserer Kunden haben ein AWS-Konto, und der Vorteil, den wir sehen, besteht darin, dass die Sicherheit ihrer Daten in ihrer privaten AWS Cloud äußerst einfach ist wenn wir in derselben Cloud ausführen.“

„Es ist viel einfacher, Zugriff auf private Bereitstellungen zu gewähren, auf denen ihre Daten ausgeführt werden, als zu versuchen, das Ganze von Grund auf neu zu erstellen.“– Joshua Pantony

Mit der zusätzlichen Sicherheit, die ein privater Endpunkt bietet, sind immer mehr Kunden bereit, ihre firmeneigenen Daten weiterzugeben, um individuellere Erkenntnisse zu gewinnen. Ein Hedgefonds könnte beispielsweise Zugriff auf Interviews mit Hunderten von CFOs und Managementanalysten haben. Dieser Datensatz ist zu wertvoll und vertraulich, als dass er an einen öffentlichen API-Endpunkt gesendet werden könnte. Mit dem domainspezifischen Ansatz von Boosted.ai ist das auch nicht nötig. Der gesamte Workload wird in der Cloud des Kunden ausgeführt, und er erhält individuellere Einblicke.

Die Zukunft: Domainspezifische Sprachmodelle und eine neue Möglichkeit, Fachwissen zu nutzen

Mit der Weiterentwicklung des fein abgestimmten kleineren Sprachmodells von Boosted.ai werden die Einblicke, die es bietet, immer präziser und quantifizierter. Aktuell kann es beispielsweise sagen, welche Unternehmen von einem Ereignis, wie dem Krieg in der Ukraine, betroffen sind. In Zukunft wird es in der Lage sein, diese Auswirkungen zu quantifizieren und festzustellen: „Genau 7 Prozent des Umsatzes dieses Unternehmens werden betroffen sein, und hier ist die Wahrscheinlichkeit, wie stark es betroffen sein wird.“

Darüber hinaus erfordert die Gewinnung dieser Erkenntnisse weniger Benutzerinteraktion. Sie können Ihr Fachwissen und Ihre Kenntnisse in Ihre personalisierte KI hochladen, diese eine riesige Datenbank mit Informationen scannen lassen, um Ihnen einzigartige Ideen zu präsentieren.

KI ist die am schnellsten übernommene Technologie in der Geschichte der Menschheit, und für kleinere Unternehmen werden die hochmodernen Anwendungsfälle von heute wahrscheinlich schon in wenigen Jahren zum Standard gehören.

„Wir befinden uns in einer wirklich einzigartigen Zeit, in der viele große Unternehmen das Potenzial dieser Technologie nicht kennen und sie auf suboptimale Weise übernehmen. Es gibt überall eine Menge Chatbots. Wenn Sie heute ein Startup sind, treffen Sie Kunden, lernen Sie ihre Probleme kennen und machen Sie sich bewusst, wozu generative KI fähig ist. Wenn Sie das tun, ist die Wahrscheinlichkeit sehr hoch, dass Sie einen einzigartigen Mehrwert erhalten.“

„Sobald Sie sicher sind, dass Ihr Produkt marktgerecht ist, würde ich über eine Feinabstimmung kleinerer Modelle gegenüber LLMs in Bezug auf Geschwindigkeit, Genauigkeit und Datensensibilität nachdenken. Wenn Sie der Meinung sind, dass eines davon für Ihren Anwendungsfall von entscheidender Bedeutung ist, lohnt es sich wahrscheinlich, ein domainspezifisches Modell zu verwenden.“– Joshua Pantony

Weiterer Dank geht an Invisible für ihre Beiträge zu diesem Projekt und Artikel. Invisible ist ein Unternehmen für Betriebsinnovation, das KI und Automatisierung nahtlos mit qualifizierten Mitarbeitern kombiniert, um strategische Engpässe bei der Umsetzung zu beseitigen.

Ryan Masciovecchio

Ryan is a Solutions Architect at AWS living in Toronto, Canada. He provides technical advice to startups, allowing them to build innovative products using emerging technologies. Ryan has over 15 years of experience, from racking servers and configuring networking appliances to building infrastructure for web applications using cloud services. Ryan enjoys learning how technology can be used in creative ways to simplify people’s lives.

Deepam Mishra

Deepam Mishra is a Sr Advisor to Startups at AWS and advises startups on ML, Generative AI, and AI Safety and Responsibility. Before joining AWS, Deepam co-founded and led an AI business at Microsoft Corporation. Deepam has been a serial entrepreneur and investor, having founded 4 AI/ML startups in areas such as security, enterprise software and healthcare. He was the VP of New Ventures at Wipro Technologies and co-founded Venture Studio, a startup incubator, and seed-fund. He has created multiple successful startups, including SightLogix, EyeIC, Green-Power-Systems, Shippr, and more. Deepam has a BSEE from IIT Kanpur, an MSEE from Texas A&M, and an MBA from The Wharton School. He has 5 US patents and numerous publications. He is based in the Silicon Valley.

Joshua Pantony

Josh is a co-founder and CEO of Boosted.ai, an AI company that brings advanced ML tools to institutional investors and wealth managers. Since starting Boosted.ai in 2017, the company has helped hundreds of investment managers implement machine learning in their portfolios. Prior to founding Boosted.ai, Josh was a Principal ML engineer at Bloomberg for 4 years. At Bloomberg, he helped start and build numerous critical ML initiatives including Ranking, Recommendation, Question and Answering, Crowd Sourcing, and Knowledge Graphs. He also acted as a consultant on numerous initiatives across the company and helped build several ML teams. As a student at the University of Waterloo, Josh co-founded his first company, Maluuba, a deep learning natural language processing company. At Maluuba, he built the earliest prototype, recruited the entire ML team, and oversaw general technology development from 4 people up to a 30 person company. He has 8 patents to his name all of which are core Maluuba IP. Maluuba was later bought by Microsoft.

Wie war dieser Inhalt?