Wie war dieser Inhalt?

Beschleunigung der KI/ML-Skalierung und KI-Entwicklung mit Anyscale und AWS

Der Aufbau einer in der Cloud verteilten und skalierbaren Anwendung für künstliche Intelligenz (KI) ist eine teamübergreifende Aufgabe, die eine komplizierte Verwaltung von Ressourcen erfordert und zahlreiche Probleme bei der Produktion mit sich bringt, wie z. B. Codeänderungen, Faktorwechsel, Einrichtung der Infrastruktur und komplexe Entwicklerabläufe (DevOps). Dies kann den Entwicklungsprozess stören, die Markteinführung verlangsamen und Entwickler davon abhalten, sich auf Produktinnovationen zu konzentrieren.

„Mangels etablierter Wege von der Entwicklung bis zur Produktion gehen einige Schätzungen davon aus, dass KI-Entwicklungsprojekte zu fast 50 % scheitern“, erklärt Rob Ferguson, Amazon Web Services (AWS) Global Head of AI and Machine Learning (ML) for Startups.

Hier helfen Anyscale, Ray (das erste einheitliche, verteilte Compute-Framework für die Skalierung von ML- oder Python-Workloads) und die Anyscale Platform (eine vollständig verwaltete Ray-Plattform, die von den Entwicklern von Ray bereitgestellt wird) KI-Teams dabei, die Entwicklung und das Experimentieren zu beschleunigen und Anwendungen mühelos zu skalieren, um den Erfolg ihrer KI-Projekte zu gewährleisten.

Ray wurde an der University of California Berkeley im RISELab entwickelt und 2017 als Open-Source Anwendung veröffentlicht. Heute wird Ray von Unternehmen auf der ganzen Welt für die Entwicklung von KI- und Python-Anwendungen in großem Maßstab eingesetzt.

Verbessern Sie Skalierbarkeit und Entwicklerergonomie mit der Anyscale Plattform

Um die KI-Entwicklung und Skalierung für jedes Unternehmen voranzutreiben, erweitert die Anyscale Platform die Möglichkeiten von Ray, indem sie Entwicklern und bereichsübergreifenden Teams die Möglichkeit gibt, Experimente zu beschleunigen und die Entwicklung von ML-Anwendungen in großem Maßstab zu beschleunigen. Die Anyscale Platform und Ray erhöhen die Geschwindigkeit der Entwickler, indem sie skalierbare Rechenleistung für die Datenaufnahme und -vorverarbeitung, das ML-Training, die Abstimmung von Hyperparametern, die Modellbereitstellung und vieles mehr bereitstellen und sich dabei nahtlos in das übrige ML-Ökosystem integrieren.

Die Anyscale Platform erweitert die Möglichkeiten von Ray erheblich. Anyscale Workspaces bietet Entwicklern eine einheitliche und nahtlose Entwicklungsumgebung, mit der sie ML-Workloads von einem Laptop in die Cloud skalieren können, ohne den Code zu ändern. Entwickler können jetzt eine einzige Umgebung nutzen, um Workloads zu erstellen, zu testen und für die Produktion bereitzustellen, während sie die Tools nutzen, mit denen sie vertraut sind. Die Anyscale Plattform verbessert die Iterationsgeschwindigkeit, indem sie die Zeit für die Einrichtung von Clustern gegenüber Ray um das Fünffache reduziert. Und schließlich bietet die Anyscale Platform standardmäßig Beobachtbarkeit, Überwachung und Job Scheduling.

„Die Möglichkeiten der Anyscale Plattform gehen weit über die Möglichkeiten von Ray hinaus und machen die Entwicklung, das Experimentieren und die Skalierung von KI/ML- und Python-Workloads noch einfacher“, sagt Ion Stoica, Mitbegründer und Executive Chairman von Anyscale. „Tausende von Unternehmen verlassen sich auf Ray, um ihre ML- und Python-Anwendungen zu skalieren, und eine wachsende Zahl von Unternehmen nutzt die Anyscale Platform, um diese Anwendungen schneller als je zuvor zu entwickeln, zu testen und in der Produktion einzusetzen.“

Von KI-Entwicklern über ML-Anwender bis hin zu Datenwissenschaftlern und Technikern – alle können von der Einfachheit, Skalierbarkeit und Entwicklerergonomie profitieren, die die Anyscale Plattform für die gesamte KI-Arbeit bietet: von der Modellentwicklung, -abstimmung und -schulung bis hin zur Inferenz und dem skalierbaren Modellservice.

Anyscale hat es sich zur Aufgabe gemacht, den Aufbau und die Skalierung von KI/ML- und Python-Workloads sowie von KI-Anwendungen zu erleichtern. Ihr Team demokratisiert KI, indem es Datenwissenschaftlern und ML-Ingenieuren die Arbeit mit Projektstrukturen erleichtert, die für den Aufbau produktiver ML-Systeme sinnvoll sind. Skalierbares, einheitliches und offenes verteiltes Computing, wie es Anyscale für Ray anbietet, trägt zur Massendemokratisierung und Industrialisierung von KI bei.

Der Einsatz von Anyscale für Open Source und die Möglichkeit der gemeinsamen Nutzung von Technologien ist offensichtlich: Das Team von Anyscale leitet die Open-Source-Community von Ray, indem es den Betrieb verwaltet, Beiträge prüft und die Community ausbaut und weiterentwickelt. Darüber hinaus ist Anyscale der größte Contributor von (OSS) und hat kürzlich Ray 2.1 veröffentlicht.

Aufbau ausgereifter, zuverlässiger und leicht skalierbarer ML-Modelle

Da 90 % aller neuen Anwendungen bis 2025 voraussichtlich cloudnativ sein werden, sieht Anyscale die Cloud als Standardumgebung, in der die nächste Generation von Anwendungen entwickelt werden wird. Sie erwarten, dass die nächste Generation der Cloud-Infrastruktur optimierte Frameworks sein werden, die die Entwicklung und Verwaltung von Anwendungen erleichtern.

Anyscale nutzt die ausgereifte Produktpalette von AWS als Komponenten für die schnelle Entwicklung seiner Plattform. Anyscale und Ray sind in AWS voll funktionsfähig, mit hocheffizienter Leistung und Skalierung. Die Skalierbarkeit von AWS ist nicht nur ein enormer Vorteil für Anyscale und Ray, sondern auch für einige ihrer größten Kunden, die seit langem AWS nutzen, was die Kundeninteraktion erleichtert.

„Inferenz macht 90 % eines jeden ML-Projekts aus. Teams für Machine Learning brauchen neue Wege, um mit verteiltem Computing zu arbeiten und die nächste Generation von ML in großem Maßstab zu liefern“, erklärt Rob. „Das goldene Zeitalter des Machine Learning ist angebrochen und AWS und Anyscale helfen Unternehmen dabei, ML-Modelle so zu erstellen, wie sie sein sollen: ausgereift, zuverlässig und leicht skalierbar.“

Amazon.com und AWS haben mit der Ray-Community zusammengearbeitet, um Ray in viele AWS-Services zu integrieren, darunter:

- AWS Identity and Access Management (IAM) für die differenzierte Zugriffskontrolle

- AWS Certificate Manager (ACM) für SSL/TLS-Verschlüsselung während der Übertragung

- AWS Key Management Service (AWS KMS) zur Verschlüsselung im Ruhezustand.

- Amazon Simple Storage Service (Amazon S3) für mehr Objektspeicher

- Amazon Elastic File System (Amazon EFS) für verteilten Dateizugriff

- Amazon CloudWatch für Beobachtbarkeit

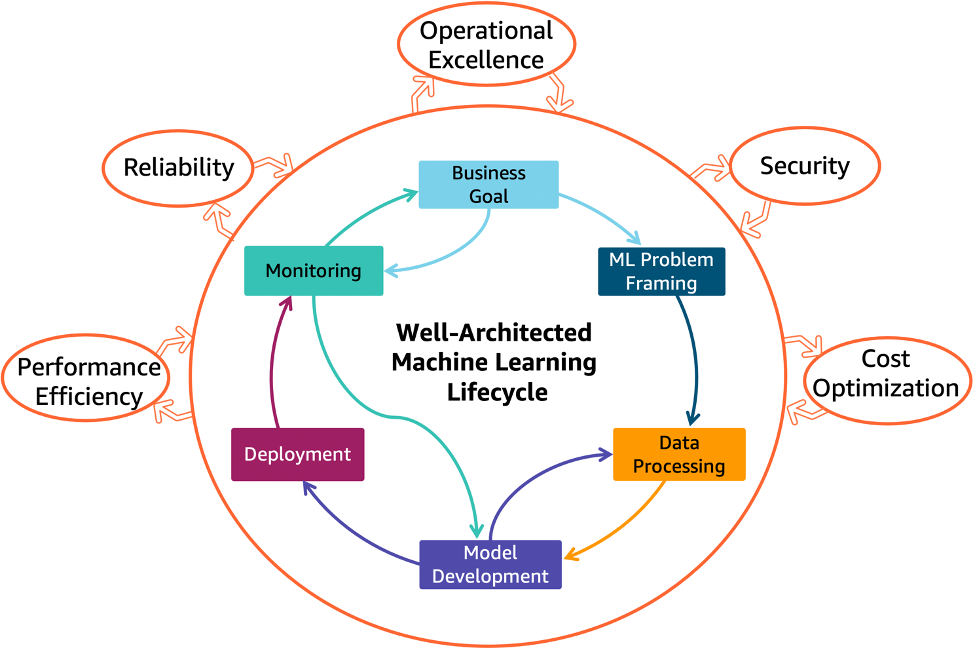

Lösungen, die in den AWS Well-Architected Machine Learning Lifecycle fallen – wie die Anyscale Platform für die Bereitstellungsphase – können Unternehmen dabei helfen, mehr Zeit auf die Produktentwicklung statt auf die Bereitstellung und Verwaltung von Ressourcen zu verwenden.

Das AWS-Well-Architected-Framework, welches bewährte Methoden für die Entwicklung und den Betrieb von Workloads in der Cloud bietet, umfasst Säulen für operative Exzellenz, Sicherheit, Zuverlässigkeit, Leistungseffizienz, Kostenoptimierung und Nachhaltigkeit. Mit der Anyscale Plattorm können Entwickler ihre Leistungseffizienz steigern.

„Anyscale vereinfacht einen typischen Python-ML-Code und hilft dabei, ihn mit nur zwei Zeilen Code in das Framework einzupassen“, erklärt Rob. „AWS ist ein unglaubliches Zuhause für Anyscale mit seinen branchenführenden Tools für Produktionssysteme sowie den umfassendsten und tiefgreifendsten Datenverarbeitungsoptionen.“

Rob Ferguson

Rob ist der Global Head of Artificial Intelligence and Machine Learning für Startups und Risikokapital bei AWS mit Sitz in San Francisco. Vor seiner Zeit bei AWS arbeitete er als CTO/VPE von zwei Y-Combinator-Startups und beschaffte über 150 Mio. USD. Er verfügt über Fachkenntnisse in den Bereichen KI/ML sowie Unterhaltungselektronik und Medien. Als CTO von Automatic Labs sicherte sich Rob einen der 10 größten Exits von Y Combinator sowie ein Produkt mit über 4,5 Sternen bei Amazon.

Ion Stoica

Stoica ist seit 2000 Professor in Berkeley. Seine Forschung umfasst Cloud-Computing, Netzwerke, verteilte Systeme und Big Data. Er hat mehr als 100 von Experten begutachtete Artikel in verschiedenen Bereichen der Informatik verfasst oder mitverfasst. Stoica war 2006 Mitgründer und Chief Technology Officer (CTO) von Conviva, einem Unternehmen, das aus dem End-System-Multicast-Projekt der CMU hervorgegangen ist. Stoica war dann Miterfinder von Apache Spark im Berkeley AMPLab. 2013 war Stoica Mitgründer von Databricks, das auf Spark basiert, und war bis 2016 als CEO tätig, als er Verwaltungsratsvorsitzender wurde. Stoica war dann Miterfinder von Ray im Berkeley RISELab. Ray ist heute das am schnellsten wachsende einheitliche Datenverarbeitungsframework zur Skalierung von KI/ML-Workloads und -Anwendungen. Stoica war 2019 Mitgründer von Anyscale, dem Unternehmen, das die Anyscale-Plattform anbietet, eine vollständig verwaltete Ray-Plattform. Ion Stoica ist derzeit neben seiner Rolle als Verwaltungsratsvorsitzender von Databricks Verwaltungsratsvorsitzender von Anyscale.

Megan Crowley

Megan Crowley ist Senior Technical Writer im Startup Content Team bei AWS. Nach einer früheren Karriere als Englischlehrerin an einer High School wird sie von einer unermüdlichen Begeisterung angetrieben, zu Inhalten beizutragen, die zu gleichen Teilen lehrreich und inspirierend sind. Die Geschichten von Startups mit der Welt zu teilen, ist der bereicherndste Teil ihrer Rolle bei AWS. In ihrer Freizeit findet man Megan bei der Holzbearbeitung, im Garten und auf Antiquitätenmärkten.

Wie war dieser Inhalt?