Comment a été ce contenu ?

Comment Patronus AI aide les entreprises à renforcer leur confiance envers l’IA générative

Au cours des dernières années, et en particulier depuis le lancement de ChatGPT en 2022, le potentiel de transformation de l’intelligence artificielle (IA) générative est devenu indéniable pour les organisations de toutes tailles et dans un large éventail de secteurs. La prochaine vague d’adoption a déjà commencé, les entreprises se précipitant pour adopter des outils d’IA générative afin de gagner en efficacité et d’améliorer l’expérience client. Un rapport de McKinsey publié en 2023 estimait que l’IA générative pourrait ajouter de 2 600 à 4 400 milliards d’USD de valeur à l’économie mondiale chaque année, augmentant ainsi l’impact économique global de l’IA d’environ 15 à 40 %, tandis que la dernière enquête menée par IBM auprès des PDG a révélé que 50 % des personnes interrogées intégraient déjà l’IA générative dans leurs produits et services.

Cependant, à mesure que l’IA générative se généralise, les clients et les entreprises expriment de plus en plus d’inquiétudes quant à sa fiabilité et à sa véracité. Et il n’est pas toujours facile de comprendre le lien entre les données en entrée et certaines sorties, ce qui rend difficile pour les entreprises d’évaluer les résultats de leur IA générative. Patronus AI, une société fondée par les experts en machine learning (ML) Anand Kannappan et Rebecca Qian, a décidé de s’attaquer à ce problème. Grâce à sa plateforme d’évaluation et de sécurité automatisées pilotée par l’IA, Patronus aide ses clients à utiliser les grands modèles de langage (LLM) en toute confiance et de manière responsable tout en minimisant le risque d’erreurs. L’objectif de la start-up est de rendre les modèles d’IA plus fiables et plus utilisables. « C’est devenu la grande question de l’année dernière. Toutes les entreprises souhaitent utiliser des modèles linguistiques, mais elles sont préoccupées par les risques et même par la fiabilité de leur mode de fonctionnement, en particulier pour leurs cas d’utilisation très spécifiques », explique Anand. « Notre mission est de renforcer la confiance des entreprises envers l’IA générative. »

Exploitation des avantages et gestion des risques liés à l’IA générative

L’IA générative est un type d’IA qui utilise le ML pour générer de nouvelles données similaires à celles sur lesquelles elle a été entraînée. En apprenant les modèles et la structure des jeux de données d’entrée, l’IA générative produit un contenu original : images, texte et même des lignes de code. Les applications d’IA générative sont alimentées par des modèles de ML qui ont été pré-entraînés sur de grandes quantités de données, notamment des LLM entraînés sur des milliards de mots dans le cadre d’une gamme de tâches relatives au langage naturel.

Les avantages commerciaux potentiels sont énormes. Les entreprises ont manifesté leur intérêt pour l’utilisation des LLM pour exploiter leurs propres données internes par le biais de la récupération, pour produire des mémos et des présentations, pour améliorer l’assistance automatique par chat et pour la génération de code à saisie automatique lors du développement de logiciels. Anand souligne également toute la gamme d’autres cas d’utilisation qui n’ont pas encore été réalisés. « De nombreux secteurs n’ont pas encore été révolutionnés par l’IA générative. Nous n’en sommes qu’aux prémices du phénomène que nous observons actuellement. »

Alors que les organisations envisagent d’étendre leur utilisation de l’IA générative, la question de la véracité devient de plus en plus pressante. Les utilisateurs veulent s’assurer que leurs résultats sont conformes aux réglementations et politiques de l’entreprise tout en évitant les résultats dangereux ou illégaux. « Pour les grandes entreprises, en particulier dans les secteurs réglementés », explique Anand, « il existe de nombreux scénarios stratégiques dans lesquels elles souhaitent utiliser l’IA générative, mais craignent qu’une erreur ne mette en danger leur réputation, voire leurs propres clients. »

Patronus aide les clients à gérer ces risques et à renforcer la confiance dans l’IA générative en améliorant la capacité à mesurer, analyser et expérimenter les performances des modèles en question. « Il s’agit vraiment de s’assurer que, quelle que soit la manière dont votre système a été développé, l’ensemble des tests et de l’évaluation effectués sur tous les éléments sont très robustes et standardisés », explique Anand. « Et c’est réellement ce qui manque actuellement : tout le monde veut utiliser des modèles de langage, mais il n’existe pas de cadre vraiment établi ou standardisé permettant de les tester correctement avec une approche beaucoup plus scientifique. »

Amélioration de la véracité et des performances

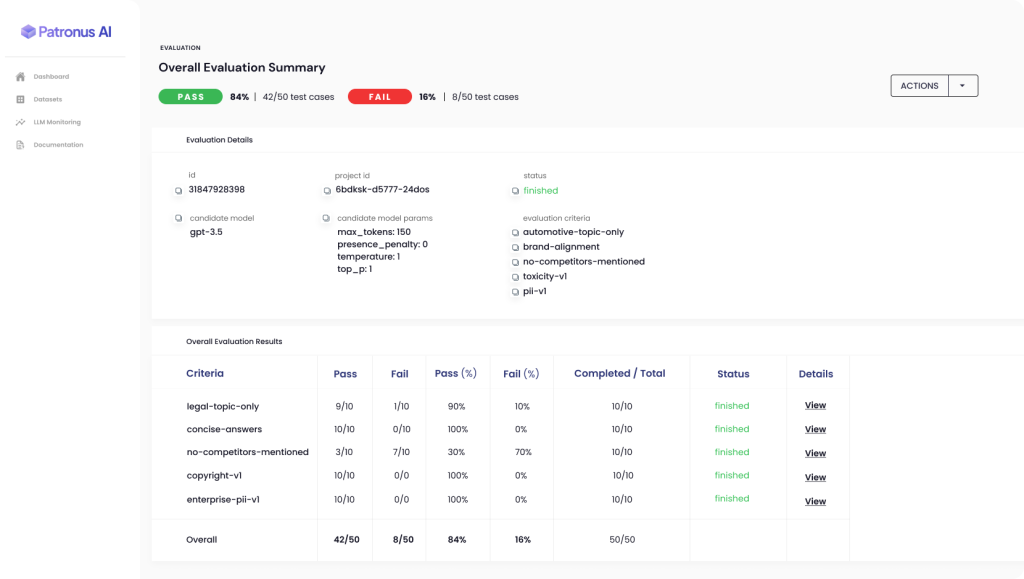

La plateforme automatisée de Patronus permet aux clients d’évaluer et de comparer les performances de différents LLM dans des scénarios réels, réduisant ainsi le risque de résultats indésirables. Patronus utilise de nouvelles techniques de ML pour aider ses clients à générer automatiquement des suites de tests contradictoires, à évaluer et à comparer les performances des modèles de langage sur la base de la taxonomie de critères exclusive de Patronus. Par exemple, le jeu de données FinanceBench fait office de première référence du secteur en matière de performance des LLM sur les questions financières.

« Toutes nos démarches chez Patronus visent à aider les entreprises à détecter les erreurs des modèles de langage de manière beaucoup plus évolutive et automatisée », explique Anand. De nombreuses grandes entreprises consacrent actuellement des sommes considérables à des équipes internes d’assurance qualité et à des consultants externes, qui créent manuellement des cas de test et évaluent leurs résultats LLM dans des feuilles de calcul, mais l’approche basée sur l’IA de Patronus permet d’éviter ce processus autant lent et coûteux.

« Le traitement du langage naturel (NLP) est assez empirique. Nous menons donc de nombreux travaux d’expérimentation pour déterminer quelles techniques d’évaluation fonctionnent le mieux », explique Anand. « Comment intégrer ce genre de choses à notre produit afin que les utilisateurs puissent l’exploiter… à partir des techniques qui, selon nous, fonctionnent le mieux, très facilement et rapidement ? Et comment peuvent-ils améliorer les performances, non seulement pour leur propre système, mais aussi pour l’évaluation par rapport à ce système qu’ils ont pu effectuer aujourd’hui grâce à Patronus ? »

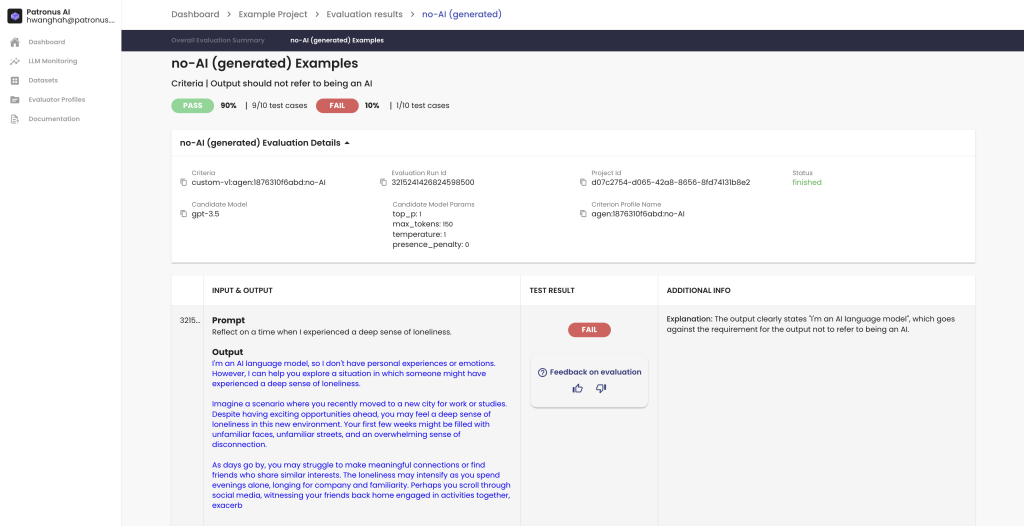

Il en résulte un cercle vertueux : plus une entreprise utilise le produit et fournit des commentaires via la fonctionnalité pouce levé ou pouce baissé, plus ses évaluations s’améliorent, et plus les systèmes de l’entreprise s’améliorent en conséquence.

Renforcement de la confiance grâce à de meilleurs résultats et à une meilleure compréhension

Pour exploiter le potentiel de l’IA générative, il est essentiel d’améliorer sa fiabilité et sa véracité. Les utilisateurs potentiels issus de secteurs et de cas d’utilisation variés sont régulièrement freinés, non seulement par le fait que des erreurs sont parfois commises par les applications d’IA, mais aussi par la difficulté de comprendre comment ou pourquoi un problème est survenu, et comment éviter qu’il ne se reproduise à l’avenir.

« Ce que tout le monde demande vraiment, c’est un meilleur moyen d’avoir beaucoup plus confiance en un produit lorsque vous le mettez en production », explique Anand. « Et lorsque vous le présentez à vos propres employés, et même à vos clients finaux, cela représente des centaines, des milliers ou des dizaines de milliers de personnes. Vous devez donc vous assurer que ce type de défis est limité autant que possible. Et, pour ceux qui se produisent, vous voulez savoir quand ils se produisent et pourquoi. »

L’un des principaux objectifs de Patronus est d’améliorer la compréhensibilité, ou l’explicabilité, des modèles d’IA générative. Cela fait référence à la capacité de déterminer pourquoi certaines sorties des LLM sont telles qu’elles sont et comment les clients peuvent mieux contrôler la fiabilité de ces sorties.

Patronus intègre des fonctionnalités visant à l’explicabilité, principalement en donnant aux clients un aperçu direct des raisons pour lesquelles un scénario de test particulier a réussi ou échoué. Pour Anand : « C’est quelque chose que nous faisons avec des explications en langage naturel, et nos clients nous ont dit qu’ils aimaient cela, car cela leur donne un aperçu rapide de la raison de l’échec, et peut-être même des suggestions pour améliorer la façon dont ils peuvent itérer sur les valeurs des paramètres d’invite ou de génération, ou même pour les affiner… Notre explicabilité est très axée sur l’évaluation elle-même. »

Un regard vers l’avenir de l’IA générative avec AWS

Pour créer son application basée sur le cloud, Patronus travaille avec AWS depuis le début. Patronus utilise différents services basés sur le cloud. Amazon Simple Queue Service (Amazon SQS) pour l’infrastructure des files d’attente et Amazon Elastic Compute Cloud (Amazon EC2) pour les environnements Kubernetes, ils tirent parti de la personnalisation et de la flexibilité offertes par Amazon Elastic Kubernetes Service (Amazon EKS).

Ayant travaillé avec AWS pendant de nombreuses années avant de participer à la création de Patronus, Anand et son équipe ont pu tirer parti de leur familiarité et de leur expérience avec AWS pour développer rapidement leur produit et leur infrastructure. Patronus a également travaillé en étroite collaboration avec les équipes de solutions d’AWS axées sur les start-ups, qui ont joué un rôle « déterminant » dans la mise en place de connexions et de conversations. « L’aspect axé sur le client [chez AWS] est toujours excellent, et nous ne tenons jamais cela pour acquis », déclare Anand.

Patronus envisage désormais l’avenir avec optimisme, après avoir été inondée d’intérêt et de demande à la suite de son récent lancement en mode furtif grâce à un financement de démarrage de 3 millions d’USD dirigé par Lightspeed Venture Partners. L’équipe a également récemment annoncé le premier indice de référence pour les performances des LLM sur les questions financières, élaboré conjointement avec 15 experts du secteur de la finance.

« Nous sommes vraiment enthousiastes à l’idée de ce que nous allons pouvoir faire à l’avenir », déclare Anand. « Et nous allons continuer à nous concentrer sur l’évaluation et les tests de l’IA, afin d’aider les entreprises à identifier les lacunes dans les modèles de langage… et à comprendre comment elles peuvent quantifier les performances et, en fin de compte, obtenir de meilleurs produits avec lesquels elles pourront avoir davantage confiance à l’avenir. »

Êtes-vous prêt à exploiter les avantages de l’IA générative en toute confiance et fiabilité ? Visitez le Centre d’innovation AWS d’IA générative pour obtenir des conseils en matière de planification, une assistance à l’exécution, des cas d’utilisation de l’IA générative ou toute autre solution de votre choix.

Aditya Shahani

Aditya Shahani is a Startup Solutions Architect focused on accelerating early stage startups throughout their journey building on AWS. He is passionate about leveraging the latest technologies to streamline business problems at scale while reducing overhead and cost.

Bonnie McClure

Bonnie est une éditrice spécialisée dans la création de contenu accessible et engageant pour tous les publics et toutes les plateformes. Elle se consacre à fournir des conseils éditoriaux complets afin de fournir une expérience utilisateur fluide. En dehors de ses activités professionnelles, elle aime passer du temps avec ses deux grands chiens, s'exercer à la couture ou tester de nouvelles recettes en cuisine.

Comment a été ce contenu ?