Was ist NeRF?

Ein neuronales Strahlungsfeld (NeRF) ist ein neuronales Netzwerk, das komplexe dreidimensionale Szenen aus einem Teilsatz zweidimensionaler Bilder rekonstruieren kann. Dreidimensionale Bilder werden in verschiedenen Simulationen, Spielen, Medien und Internet-der-Dinge-(IoT)-Anwendungen benötigt, um digitale Interaktionen realistischer und genauer zu gestalten. Das NeRF lernt die Szenengeometrie, Objekte und Winkel einer bestimmten Szene. Anschließend rendert es fotorealistische 3D-Ansichten aus neuen Blickwinkeln und generiert automatisch synthetische Daten, um Lücken zu schließen.

Was sind die Anwendungsfälle neuronaler Strahlungsfelder?

NeRFs können komplexe Szenen rendern und Bilder für verschiedene Anwendungsfälle generieren.

Computergrafik und Animation

In der Computergrafik können Sie NeRFs verwenden, um realistische visuelle Effekte, Simulationen und Szenen zu erstellen. NeRFs erfassen, rendern und projizieren lebensechte Umgebungen, Charaktere und andere Bilder. NeRFs werden häufig zur Verbesserung von Videospielgrafiken und VX-Filmanimationen verwendet.

Medizinische Bildgebung

NeRFs ermöglichen die Erstellung umfassender anatomischer Strukturen aus 2D-Scans wie MRTs. Die Technologie kann realistische Darstellungen von Körpergewebe und Organen rekonstruieren und bietet Ärzten und Medizintechnikern einen nützlichen visuellen Kontext.

Virtual Reality

NeRFs sind eine wichtige Technologie in Virtual-Reality- und Augmented-Reality-Simulationen. Da sie 3D-Szenen präzise modellieren können, erleichtern sie die Erstellung und Erkundung realistischer virtueller Umgebungen. Je nach Blickrichtung kann NeRF neue visuelle Informationen anzeigen und sogar virtuelle Objekte in einem realen Raum rendern.

Satellitenbilder und Planung

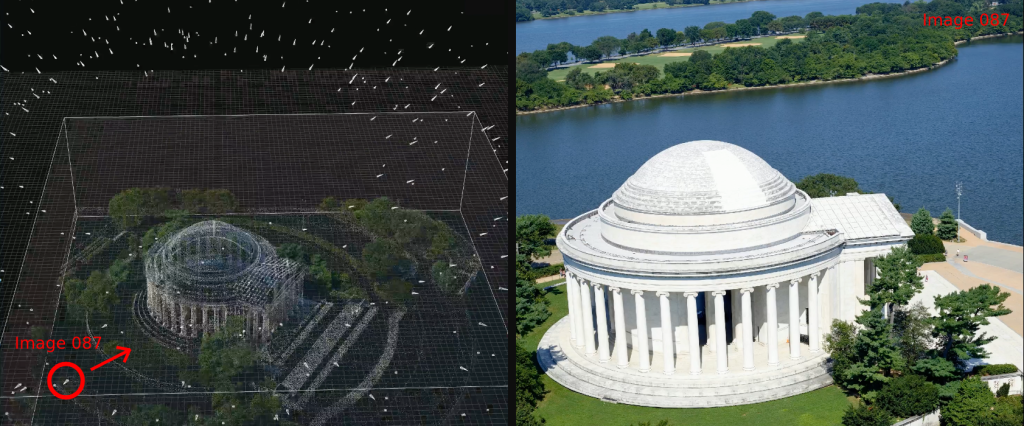

Satellitenbilder bieten eine Reihe von Bildern, die NeRFs verwenden können, um umfassende Modelle der Erdoberfläche zu erstellen. Es ist nützlich für Anwendungsfälle der Realitätserfassung (RC), in denen reale Umgebungen digitalisiert werden müssen. Sie können räumliche Positionsdaten in hochdetaillierte 3D-Modelle umwandeln. Beispielsweise wird die Rekonstruktion von Luftbildern in Landschaftsrenderings häufig in der Stadtplanung verwendet, da sie eine nützliche Referenz für die reale Gestaltung eines Gebiets bietet.

Die folgende Abbildung zeigt ein Beispiel für ein 3D-Gebäudemodell.

Wie funktionieren neuronale Strahlungsfelder?

Computergerenderte 3D-Bilder, die mit verschiedenen digitalen Grafiktechniken erstellt wurden, besitzen mehrere unterschiedliche Eigenschaften, die ihre Qualität und ihren Realismus definieren. Beispiel:

- Geometrische Aspekte wie Positionierung, Ausrichtung und Maßstab von 3D-Modellen in der Szene

- Lichtaspekte wie Schatten, Helligkeit, Farbe und Reflexionen

- Transparenz und Transluzenz, die zeigen, wie Licht durch Materialien wie Glas oder Nebel fällt

- Volumen und Dichte, z. B. die Dichte von Rauch oder Wolken

- Texturen, die Materialien wie Stoff, Holz oder Metall simulieren

Die Wahl der Farben und deren Verteilung spielen ebenfalls eine wichtige Rolle für die visuelle Wirkung des Bildes. Die Schattierung bestimmt, wie verschiedene Oberflächenbereiche beleuchtet werden, wodurch ein Gefühl von Tiefe und Form entsteht.

NeRFs kombinieren Techniken der Computergrafik mit neuronaler Netzwerkarchitektur, um alle oben genannten Aspekte zu bewältigen.

Das folgende Bild ist ein Beispiel für ein computergerendertes 3D-Bild.

Architektur neuronaler Strahlungsfelder

NeRFs verwenden einen neuronalen Aspekt namens Multilayer Perceptron (MLP) – eine vollständig verbundene neuronale Netzwerkarchitektur –, um eine Darstellung einer 3D-Szene zu erstellen. Ein MLP ist ein grundlegendes Modell für neuronale Netzwerke und Deep Learning. Es ist darauf trainiert, räumliche Koordinaten und Blickrichtungen Farb- und Dichtewerten zuzuordnen. Ein MLP verwendet eine Reihe mathematischer Strukturen, die Eingaben – z. B. eine Position im 3D-Raum oder eine 2D-Betrachtungsrichtung – organisieren, um die Farb- und Dichtewerte an jedem Punkt in einem 3D-Bild zu bestimmen.

Das Netzwerk lernt auch, die Helligkeit und Farbe der Lichtstrahlen in der Szene zu ändern. Durch die Entwicklung eines Verständnisses dieser Strahlen, bekannt als Radianzmodellierung, können verschiedene Farben und Dichten aus verschiedenen Perspektiven dargestellt werden.

Weitere Informationen über Deep Learning

Arten neuronaler Strahlungsfelder

Die ersten Versionen von NeRFs waren schwierig zu optimieren und zu verlangsamen, und sie benötigten Eingaben von Fotos, um die Beleuchtung mit denselben Kamerastrahlen anzupassen. Seitdem haben sich mehrere Varianten gegenüber der ursprünglichen Technologie verbessert.

PixelNeRF

Eine der frühesten neuen Formen von NeRF war der PixelNeRF (CPVR 2021). Mit dieser Bereitstellung wird eine vollständig konvolutionale Architektur eingeführt, die von einzelnen Bildeingaben abhängig sein kann. Dieser Ansatz macht viele kalibrierte und organisierte Ansichten überflüssig und reduziert die insgesamt benötigten Rechenressourcen. Dieser neue Ansatz rationalisierte den Prozess der Erstellung und Optimierung von NeRFs.

Mega-NeRD

Mega-NeRD (CVPR 2022) ist ein weiteres NeRF-Framework, das besonders bei der Arbeit mit großen Szenen nützlich ist. Es bietet einen alternativen geometrischen Clustering-Algorithmus und eine spärliche Netzwerkstruktur, die es ihm ermöglichen, Bilder mit unterschiedlichen Lichtverhältnissen zu verarbeiten. Dieses optimierte NeRF verwendet ein Sparse Neural Radiance Grid (SNeRG), um reale Umgebungen effektiv zu erfassen und zu rendern.

NSVF

Neural Sparse Voxel Fields (NSVF) ist ein NeRF, das während der Renderphase leere Pixel überspringen kann, was die Rendergeschwindigkeit erhöht. Diese Technik erlernt Pixelstrukturen in Netzwerkzellen und ermöglicht es so, qualitativ hochwertige Bilder zu erstellen, ohne dass bestimmte Blickwinkel erforderlich sind.

Plenoptic Voxel

Anstatt das mehrschichtige neuronale Perzeptron-Netzwerk zu verwenden, verwendet Innovation Plenoptic Voxel (2021) ein Sparsee 3D grid. Mit diesem Raster können Sie die Rendergeschwindigkeit neuer Simulationen erhöhen und gleichzeitig die visuelle Genauigkeit durch Voxelinterpolation beibehalten.

Wie rendern neuronale Strahlungsfelder Bilder?

Neural Rendering ist die Bezeichnung für den Prozess der Bilderzeugung durch das NeRF. NeRFs verwenden verschiedene Techniken, um Rohdaten in detaillierte 3D-Darstellungen umzuwandeln.

Graphics Rendering

Rendering-Techniken aus dem Bereich der Computergrafik ermöglichen es NeRF-Modellen, Szenen geometrisch zu projizieren und zu manipulieren. Beispiel:

- Raycasting simuliert die Perspektive des Benutzers, um die Sichtbarkeit von Objekten zu berechnen

- Raytracing erweitert dieses Konzept, indem es das physikalische Verhalten von Licht, einschließlich Reflexion, Brechung und Schatten, simuliert.

- Die Rasterung wandelt 3D-Vektorinformationen auf einem 2D-Bildschirm in Pixel um. Dabei werden verschiedene Algorithmen verwendet, um Licht- und Textureffekte effizient zu simulieren.

Volume-Rendering

Volume-Rendering ist eine weitere wichtige Strategie. Ein Algorithmus bestimmt die Rot-, Grün-, Blau- und Alphawerte (Volumendichte) für jedes Pixel in einem 3D-Raum oder Bild. Diese Abbildungen werden ihren entsprechenden Positionen in einem 2D-Bild zugeordnet.

Eine andere Technik ist die View-Synthese, die umgekehrt zum Volume-Rendering funktioniert. Diese Technik erstellt eine 3D-Ansicht aus einer Reihe von 2D-Bildern. Die Ansichtssynthese erstellt ein hemisphärisches Layout, das das Objekt anhand einer Reihe von Bildern darstellt, die aus verschiedenen Blickwinkeln aufgenommen wurden. Dieser Prozess passt jedes 2D-Bild an seine jeweilige Position um ein Objekt an und rekonstruiert es in 3D.

Wie kann AWS Ihre Anforderungen an neuronale Strahlungsfelder unterstützen?

Amazon Web Services (AWS) bietet zwei Services zur Unterstützung Ihrer NeRF-Anforderungen.

AWS RoboMaker ist ein Cloud-basierter Simulationsservice, den Sie verwenden können um Simulation auszuführen, zu skalieren und zu automatisieren, ohne eine Infrastruktur verwalten zu müssen. AWS RoboMaker macht das Erstellen von Simulationsumgebungen schneller und kostengünstiger, indem es Simulationswelten und verschiedene 3D-Assets bereitstellt. Sie können diese Simulationsressourcen verwenden, um Simulationsumgebungen zu erstellen, die dem erforderlichen Maß an Genauigkeit entsprechen. Mit AWS RoboMaker WorldForge können Sie in wenigen Minuten Hunderte von benutzerdefinierten, vielfältigen 3D-Simulationswelten für Innenräume generieren.

AWS IoT TwinMaker ist ein Service, der digitale Zwillinge von realen Systemen wie Gebäuden, Fabriken, industrieller Ausrüstung und Produktionslinien erstellt. Er bietet die Möglichkeit, vorhandene Daten aus mehreren Quellen zu verwenden, virtuelle Repräsentationen jeder physischen Umgebung zu erstellen und vorhandene 3D-Modelle mit realen Daten zu kombinieren. Mit AWS IoT TwinMaker können Sie digitale Zwillinge nutzen, um schneller und mit weniger Aufwand einen ganzheitlichen Überblick über Ihre Abläufe zu erstellen.

Beginnen Sie mit neuronalen Strahlungsfeldern auf AWS, indem Sie noch heute ein Konto erstellen.

Nächste Schritte in AWS

Sie erhalten sofort Zugriff auf das kostenlose Kontingent von AWS.

Starten Sie mit der Entwicklung in der AWS-Managementkonsole.