Was ist generative KI?

Generative künstliche Intelligenz, auch als generative KI oder kurz Gen-KI bezeichnet, ist eine Art von KI, die neue Inhalte und Ideen erstellen kann, darunter Gespräche, Geschichten, Bilder, Videos und Musik. Sie kann menschliche Sprache, Programmiersprachen, Kunst, Chemie, Biologie oder jedes andere komplexe Thema lernen. Sie verwendet sein Wissen erneut, um neue Probleme zu lösen.

Sie kann beispielsweise englischen Wortschatz lernen und aus den Wörtern, die verarbeitet werden, ein Gedicht erstellen.

Ihr Unternehmen kann generative KI für verschiedene Zwecke nutzen, etwa für Chatbots, Medienerstellung, Produktentwicklung und Design.

Beispiele für generative KI

Generative KI verfügt über mehrere Anwendungsfälle in verschiedenen Branchen

Finanzdienstleistungen

Finanzdienstleistungsunternehmen nutzen generative KI-Tools, um ihren Kunden einen besseren Service zu bieten und gleichzeitig die Kosten zu senken:

- Finanzinstitute nutzen Chatbots, um Produktempfehlungen zu generieren und auf Kundenanfragen zu reagieren, was den Kundenservice insgesamt verbessert.

- Kreditinstitute beschleunigen Kreditgenehmigungen für finanziell unterversorgte Märkte, insbesondere in Entwicklungsländern.

- Banken erkennen Betrug bei Forderungen, Kreditkarten und Krediten schnell.

- Wertpapierfirmen nutzen die Möglichkeiten der generativen KI, um ihren Kunden sichere, personalisierte Finanzberatung zu geringen Kosten anzubieten.

Weitere Informationen über generative KI für Finanzdienstleistungen in AWS

Gesundheitswesen und Biowissenschaften

Einer der vielversprechendsten Anwendungsfälle generativer KI ist die Beschleunigung der Arzneimittelentdeckung und -forschung. Generative KI kann neuartige Proteinsequenzen mit spezifischen Eigenschaften für die Entwicklung von Antikörpern, Enzymen, Impfstoffen und Gentherapien erstellen.

Unternehmen aus dem Gesundheits- und Biowissenschaftssektor nutzen generative KI-Tools, um synthetische Gensequenzen für Anwendungen in der synthetischen Biologie und in der Stoffwechsel-Technik zu entwerfen. Sie können beispielsweise neue Biosynthesewege entwickeln oder die Genexpression für Zwecke der Bioproduktion optimieren.

Generative KI-Tools erstellen auch synthetische Patienten- und Gesundheitsdaten. Diese Daten können zum Trainieren von KI-Modellen, zum Simulieren klinischer Studien oder zum Studium seltener Krankheiten nützlich sein, ohne dass Zugriff auf große reale Datensätze besteht.

Weitere Informationen über generative KI im Gesundheitswesen und in den Biowissenschaften in AWS

Automobilindustrie und Fertigung

Automobilunternehmen nutzen generative KI-Technologie für viele Zwecke, von der Technik bis hin zu Erlebnissen im Fahrzeug und Kundenservice. Sie optimieren beispielsweise das Design mechanischer Teile, um den Luftwiderstand in der Fahrzeugkonstruktion zu verringern, oder passen das Design persönlicher Assistenten an.

Autounternehmen nutzen generative KI-Tools, um einen besseren Kundenservice zu bieten, indem sie schnelle Antworten auf die häufigsten Kundenfragen geben. Generative KI schafft neue Materialien, Chips und Teiledesigns, um Herstellungsprozesse zu optimieren und Kosten zu senken.

Ein weiterer Anwendungsfall für generative KI ist die Synthese von Daten zum Testen von Anwendungen. Dies ist besonders hilfreich für Daten, die nicht oft in Test-Datensätzen enthalten sind (z. B. Fehler oder Grenzfälle).

Weitere Informationen zu generativer KI für die Automobilindustrie in AWS

Weitere Informationen zu generativer KI in der Fertigung in AWS

Telekommunikation

Bei generativen KI-Anwendungsfällen in der Telekommunikation geht es darum, das Kundenerlebnis neu zu erfinden, das durch die kumulativen Interaktionen von Subscribern über alle Berührungspunkte der Kundenreise hinweg definiert wird.

Beispielsweise setzen Telekommunikationsunternehmen generative KI ein, um den Kundenservice mit menschenähnlichen Live-Gesprächspartnern zu verbessern. Sie erfinden Kundenbeziehungen mit personalisierten persönlichen Verkaufsassistenten neu. Darüber hinaus optimieren sie die Netzwerkleistung, indem sie Netzwerkdaten analysieren und Korrekturen empfehlen.

Weitere Informationen zu generativer KI für Telekommunikation in AWS

Medien und Unterhaltung

Von Animationen und Drehbüchern bis hin zu Filmen in voller Länge produzieren generative KI-Modelle neuartige Inhalte zu einem Bruchteil der Kosten und in der Zeit einer herkömmlichen Produktion.

Weitere Anwendungsfälle für generative KI in der Branche sind:

- Künstler können ihre Alben mit KI-generierter Musik ergänzen und verbessern und so völlig neue Erlebnisse schaffen.

- Medienunternehmen nutzen generative KI, um das Erlebnis ihres Publikums durch das Anbieten personalisierter Inhalte und Anzeigen zu verbessern und so ihre Umsätze zu steigern.

- Spieleunternehmen nutzen generative KI, um neue Spiele zu erstellen und Spielern die Erstellung von Avataren zu ermöglichen.

Vorteile generativer KI

Laut Goldman Sachs könnte generative KI das globale Bruttoinlandsprodukt (BIP) um 7 Prozent (oder fast 7 Billionen USD) steigern und das Produktivitätswachstum innerhalb von zehn Jahren um 1,5 Prozentpunkte erhöhen. Als Nächstes zeigen wir einige weitere Vorteile der generativen KI.

Wie hat sich die Technologie der generativen KI entwickelt?

Primitive generative Modelle werden seit Jahrzehnten in der Statistik verwendet, um die numerische Datenanalyse zu unterstützen. Neuronale Netzwerke und Deep Learning waren die jüngsten Vorläufer moderner generativer KI. Variationelle Auto-Encoder, die 2013 entwickelt wurden, waren die ersten tiefengenerativen Modelle, die realistische Bilder und Sprache erzeugen konnten.

VAEs

VAEs (Variational Autoencoder) führten die Möglichkeit ein, neuartige Variationen mehrerer Datentypen zu erstellen. Dies führte zur raschen Entstehung anderer Modelle der generativen KI wie generative gegnerische Netzwerke und Diffusionsmodellen. Diese Innovationen konzentrierten sich auf die Generierung von Daten, die trotz ihrer künstlichen Erstellung zunehmend realen Daten ähnelten.

Transformatoren

Im Jahr 2017 kam es mit der Einführung von Transformatoren zu einem weiteren Wandel in der KI-Forschung. Transformatoren integrierten die Encoder- und Decoder-Architektur nahtlos mit einem Aufmerksamkeitsmechanismus. Sie optimierten den Trainingsprozess von Sprachmodellen mit außergewöhnlicher Effizienz und Vielseitigkeit. Bemerkenswerte Modelle wie GPT erwiesen sich als grundlegende Modelle, die in der Lage waren, umfangreiche Rohtextkorpora vorab zu trainieren und für verschiedene Aufgaben zu optimieren.

Transformatoren veränderten, was für die Verarbeitung natürlicher Sprache möglich war. Sie ermöglichten generative Fähigkeiten für Aufgaben, die von der Übersetzung und Zusammenfassung bis hin zur Beantwortung von Fragen reichten.

Blick in die Zukunft

Viele Modelle der generativen KI machen weiterhin erhebliche Fortschritte und haben branchenübergreifende Anwendungen gefunden. Jüngste Innovationen konzentrieren sich auf die Verfeinerung von Modellen für die Arbeit mit proprietären Daten. Forscher wollen auch Texte, Bilder, Videos und Sprache erstellen, die immer menschenähnlicher werden.

Wie funktioniert generative KI?

Wie jede künstliche Intelligenz arbeitet auch die generative KI mit Machine-Learning-Modellen – sehr großen Modellen, die anhand riesiger Datenmengen vorab trainiert werden.

Basismodelle

Basismodelle (FMs) sind ML-Modelle, die auf einem breiten Spektrum generalisierter und unbeschrifteter Daten trainiert wurden. Sie sind in der Lage, eine Vielzahl von allgemeinen Aufgaben auszuführen.

Basismodelle sind das Ergebnis der neuesten Fortschritte in einer Technologie, die sich seit Jahrzehnten weiterentwickelt hat. Im Allgemeinen verwendet ein FM erlernte Muster und Beziehungen, um das nächste Element in einer Sequenz vorherzusagen.

Bei der Image-Generierung analysiert das Modell beispielsweise das Image und erstellt eine schärfere, klarer definierte Version des Images. Ähnlich verhält es sich bei Texten. Das Modell sagt das nächste Wort in einer Textfolge auf der Grundlage der vorangegangenen Wörter und ihres Kontexts voraus. Anschließend wählt es das nächste Wort mithilfe von Wahrscheinlichkeits-Verteilungstechniken aus.

Große Sprachmodelle

Große Sprachmodelle (LLMs) sind eine Klasse von FMs. Bei den generativen vorab trainierten Transformator (GPT)-Modellen von OpenAI handelt es sich beispielsweise um LLMs. LLMs konzentrieren sich speziell auf sprachbasierte Aufgaben wie Zusammenfassung, Textgenerierung, Klassifizierung, offene Konversation und Informationsextraktion.

Weitere Informationen über GPT »

Das Besondere an LLMs ist ihre Fähigkeit, mehrere Aufgaben auszuführen. Sie können dies tun, weil sie viele Parameter enthalten, die es ihnen ermöglichen, fortgeschrittene Konzepte zu erlernen.

Ein LLM wie GPT-3 kann Milliarden von Parametern berücksichtigen und hat die Fähigkeit, Inhalte aus sehr wenigen Eingaben zu generieren. Sie werden mit Daten aus dem Internet in riesigen Mengen vorab trainiert und erlernen dabei die verschiedensten Formen und unzählige Muster kennen. Auf diese Weise lernen die LLMs, ihr Wissen in einer Vielzahl von Kontexten anzuwenden.

Wie funktionieren Modelle der generativen KI?

Herkömmliche Modelle für Machine Learning waren unterschiedlich oder konzentrierten sich auf die Klassifizierung von Datenpunkten. Sie versuchten, die Beziehung zwischen bekannten und unbekannten Faktoren zu bestimmen. Sie betrachten zum Beispiel Bilder – bekannte Daten wie Pixelanordnung, Linien, Farben und Formen – und ordnen sie Wörtern zu – dem unbekannten Faktor. Mathematisch funktionierten die Modelle, indem sie Gleichungen identifizierten, die unbekannte und bekannte Faktoren numerisch als x- und y-Variablen abbilden konnten. Generative Modelle gehen noch einen Schritt weiter. Anstatt eine Bezeichnung anhand bestimmter Features vorherzusagen, versuchen sie, Features mit einer bestimmten Bezeichnung vorherzusagen. Mathematisch berechnet die generative Modellierung die Wahrscheinlichkeit, dass X und Y zusammen auftreten. Sie lernt die Verteilung verschiedener Datenmerkmale und deren Beziehungen kennen. Generative Modelle analysieren beispielsweise Tierbilder, um Variablen wie unterschiedliche Ohrformen, Augenformen, Schwanzmerkmale und Hautmuster aufzuzeichnen. Sie lernen Merkmale und ihre Beziehungen kennen, um zu verstehen, wie verschiedene Tiere im Allgemeinen aussehen. Sie können dann neue Tierbilder nachstellen, die nicht im Trainingssatz enthalten waren. Als Nächstes zeigen wir Ihnen einige breite Kategorien der Modelle der generativen KI.

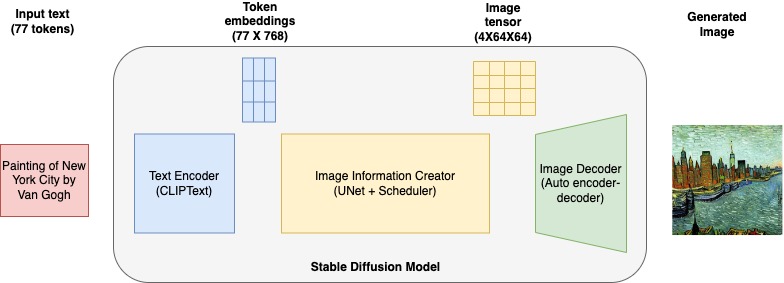

Diffusionsmodelle

Diffusionsmodelle erzeugen neue Daten, indem sie iterativ kontrollierte zufällige Änderungen an einer ersten Daten-Stichprobe vornehmen. Sie beginnen mit den Originaldaten und fügen subtile Änderungen (Rauschen) hinzu, wodurch sie dem Original zunehmend weniger ähnlich werden. Dieses Rauschen wird sorgfältig kontrolliert, um sicherzustellen, dass die generierten Daten kohärent und realistisch bleiben.

Nach dem Hinzufügen von Rauschen bei mehreren Iterationen kehrt das Diffusionsmodell den Prozess um. Durch die umgekehrte Rauschunterdrückung wird das Rauschen schrittweise entfernt, sodass ein neues Datenmuster entsteht, das dem Original ähnelt.

Generative gegnerische Netzwerke

Das generatives adverser Netzwerk (GAN) ist ein weiteres generatives KI-Modell, das auf dem Konzept des Diffusionsmodells aufbaut.

GANs arbeiten, indem sie zwei neuronale Netzwerke auf kompetitive Weise trainieren. Das erste Netzwerk, als Generator bekannt, generiert gefälschte Datenproben, indem es zufälliges Rauschen hinzufügt. Das zweite Netzwerk, der sogenannte Diskriminator, versucht, zwischen echten Daten und gefälschten Daten zu unterscheiden, die vom Generator erzeugt werden.

Während des Trainings verbessert der Generator kontinuierlich seine Fähigkeit, realistische Daten zu erzeugen, während der Diskriminator besser darin wird, echte von falschen Daten zu unterscheiden. Dieser gegnerische Prozess setzt sich fort, bis der Generator Daten erzeugt, die so überzeugend sind, dass der Diskriminator sie nicht von echten Daten unterscheiden kann.

GANs werden häufig zur Generierung realistischer Bilder, zur Stilübertragung und zur Datenerweiterung verwendet.

Variationelle Auto-Encoder

Variationelle Auto-Encoder (VAEs) lernen eine kompakte Darstellung von Daten, die als latente Umgebung bezeichnet wird. Die latente Umgebung ist eine mathematische Darstellung der Daten. Sie können sie sich als einen eindeutigen Code vorstellen, der die Daten anhand all ihrer Attribute darstellt. Wenn Sie beispielsweise Gesichter untersuchen, enthält die Latenzumgebung Zahlen, die die Augenform, die Nasenform, die Wangenknochen und die Ohren angeben.

VAEs verwenden zwei neuronale Netzwerke – den Encoder und den Decoder. Das neuronale Netzwerk des Encoders ordnet die Eingabedaten einem Mittelwert und einer Varianz für jede Dimension der latenten Umgebung zu. Das Netzwerk generiert eine zufälligen Stichprobe aus einer Gaußschen Normalverteilung. Dieses Beispiel ist ein Punkt in der latenten Umgebung und stellt eine komprimierte, vereinfachte Version der Eingabedaten dar.

Das neuronale Netzwerk des Decoders nimmt diese Stichprobe aus der latenten Umgebung und rekonstruiert ihn wieder in Daten, die der ursprünglichen Eingabe ähneln. Mathematische Funktionen werden verwendet, um zu messen, wie gut die rekonstruierten Daten mit den Originaldaten übereinstimmen.

Transformator-basierte Modelle

Das Transformator-basierte Modell der generativen KI baut auf den Encoder- und Decoder-Konzepten von VAEs auf. Transformator-basierte Modelle fügen dem Encoder weitere Ebenen hinzu, um die Leistung bei textbasierten Aufgaben wie das Verstehen, Übersetzen und kreatives Schreiben zu verbessern.

Transformator-basierte Modelle verwenden einen Selbstaufmerksamkeitsmechanismus. Sie wägen die Bedeutung verschiedener Teile einer Eingabesequenz bei der Verarbeitung jedes Elements in der Sequenz ab.

Ein weiteres wichtiges Feature ist, dass diese KI-Modelle kontextbezogene Einbettungen implementieren. Die Kodierung eines Sequenzelements hängt nicht nur vom Element selbst ab, sondern auch von seinem Kontext innerhalb der Sequenz.

Funktionsweise Transformator-basierter Modelle

Um zu verstehen, wie Transformator-basierte Modelle funktionieren, stellen Sie sich einen Satz als eine Folge von Wörtern vor.

Die Selbstaufmerksamkeit hilft dem Modell dabei, sich bei der Verarbeitung jedes Wortes auf die relevanten Wörter zu konzentrieren. Das Transformer-basierte generative Modell verwendet mehrere Encoder-Ebenen, sogenannte Attention Heads, um unterschiedliche Beziehungstypen zwischen Wörtern zu erfassen. Jeder Kopf lernt, auf unterschiedliche Teile der Eingabesequenz zu achten, wodurch das Modell verschiedene Aspekte der Daten gleichzeitig berücksichtigen kann.

Jede Ebene verfeinert außerdem die kontextbezogene Einbettungen, wodurch sie informativer werden und alles von der Grammatiksyntax bis hin zu komplexen semantischen Bedeutungen erfasst wird.

Generatives KI-Training für Anfänger

Generatives KI-Training beginnt mit dem Verständnis grundlegender Konzepte des Machine Learning. Lernende müssen sich auch mit neuronalen Netzwerken und der KI-Architektur befassen. Praktische Erfahrung mit Python-Bibliotheken wie TensorFlow oder PyTorch ist für die Implementierung und das Experimentieren mit verschiedenen Modellen unerlässlich. Sie müssen außerdem die Fähigkeiten zur Modellevaluierung, Feinabstimmung und Prompt-Engineering erlernen.

Ein Abschluss in Künstlicher Intelligenz oder Machine Learning bietet eine fundierte Ausbildung. Erwägen Sie zur beruflichen Weiterentwicklung die Nutzung kurzer Online-Kurse und Zertifizierungen. Generatives KI-Training in AWS beinhaltet Zertifizierungen durch AWS-Experten zu Themen wie:

- Einführung in generative KI

- Generative KI für Führungskräfte

- Grundlagen der generativen KI für Unternehmen

Welche Einschränkungen gibt es bei generativer KI?

Trotz ihres Fortschritts können Generative-KI-Systeme manchmal ungenaue oder irreführende Informationen liefern. Sie stützen sich auf Muster und Daten, auf denen sie trainiert wurden, und können Verzerrungen oder Ungenauigkeiten widerspiegeln, die in diesen Daten enthalten sind. Zu den weiteren Bedenken im Zusammenhang mit Trainingsdaten gehören

Sicherheit

Datenschutz- und Sicherheitsbedenken entstehen, wenn geschützte Daten zur Anpassung generativer KI-Modelle verwendet werden. Es muss sichergestellt werden, dass die Generative-KI-Tools Antworten erzeugen, die den unbefugten Zugriff auf geschützte Daten begrenzen. Sicherheitsbedenken entstehen auch, wenn es an Nachvollziehbarkeit und Transparenz bei der Entscheidungsfindung von KI-Modellen mangelt.

Weitere Informationen über den sicheren Ansatz für generative KI mit AWS

Kreativität

Generative KI kann zwar kreative Inhalte produzieren, es fehlt ihr jedoch oft an echter Originalität. Die Kreativität der KI wird durch die Daten begrenzt, mit denen sie trainiert wurde, was zu Ergebnissen führen kann, die sich repetitiv oder abgeleitet anfühlen. Menschliche Kreativität, die ein tieferes Verständnis und emotionale Resonanz voraussetzt, ist für die KI nach wie vor eine Herausforderung, wenn es darum geht, sie vollständig zu reproduzieren.

Kosten

Das Trainieren und Ausführen generativer KI-Modelle erfordert erhebliche Rechenressourcen. Cloudbasierte Generative-KI-Modelle sind zugänglicher und kostengünstiger als der Versuch, neue Modelle von Grund auf zu erstellen.

Erklärbarkeit

Aufgrund ihrer komplexen und undurchsichtigen Natur werden Generative-KI-Modelle oft als Black Boxes betrachtet. Es ist schwierig zu verstehen, wie diese Modelle zu bestimmten Ergebnissen kommen. Die Verbesserung der Interpretierbarkeit und Transparenz ist unerlässlich, um das Vertrauen und die Akzeptanz zu erhöhen.

Was sind die Bet Practices bei der Einführung generativer KI?

Wenn Ihr Unternehmen Lösungen der generativen KI implementieren möchte, sollten Sie die folgenden Best Practices in Betracht ziehen, um Ihre Bemühungen zu verbessern.

Wie kann AWS die generative KI unterstützen?

Amazon Web Services (AWS) macht es einfach, Anwendungen der generativen KI für Ihre Daten, Anwendungsfälle und Kunden zu erstellen und zu skalieren. Mit generativer KI in AWS erhalten Sie Sicherheit und Datenschutz auf Unternehmensebene, Zugriff auf branchenführende FMs, generative KI-gestützte Anwendungen und einen datenorientierten Ansatz.